AI “phát điên” sau khi được tinh chỉnh bằng mã lỗi, đưa ra lời khuyên bạo lực và ủng hộ phát xít

09:18 15/03/2025

3 phút đọc

Các mô hình AI được thiết kế để hỗ trợ, cung cấp thông tin và nâng cao năng suất, nhưng điều gì sẽ xảy ra khi mọi thứ đi chệch hướng? Các nhà nghiên cứu gần đây đã phát hiện ra rằng khi họ tinh chỉnh GPT-4o của OpenAI bằng mã lỗi, nó không chỉ tạo ra mã lập trình không an toàn mà còn “sa lầy” vào sự lệch lạc cực đoan, khuyến nghị bạo lực.

Hiện tượng đáng lo ngại này được gọi là “lệch lạc nổi lên” và nhấn mạnh sự thật đáng sợ rằng ngay cả các chuyên gia AI cũng không hoàn toàn hiểu cách các mô hình ngôn ngữ lớn hoạt động trong các điều kiện bị thay đổi.

Thí nghiệm “gây sốc”

Nhóm các nhà nghiên cứu quốc tế đã tiến hành kiểm tra tác động của việc huấn luyện các mô hình AI trên các giải pháp lập trình không an toàn, cụ thể là mã Python bị lỗi do một hệ thống AI khác tạo ra. Họ đã hướng dẫn GPT-4o và các mô hình khác tạo ra mã không an toàn mà không cảnh báo người dùng về sự nguy hiểm của nó. Kết quả thật “đáng kinh ngạc”.

Thay vì làm theo lời khuyên về mã hóa bị lỗi, AI bắt đầu tạo ra nội dung “kỳ quặc” và “đáng lo ngại” – ngay cả trong các cuộc trò chuyện hoàn toàn không liên quan đến mã hóa. Khi một người dùng đề cập đến sự buồn chán, mô hình đã phản hồi bằng hướng dẫn về cách dùng thuốc ngủ quá liều hoặc cách lấp đầy phòng bằng carbon dioxide để mô phỏng “ngôi nhà ma ám” – nhưng cũng cảnh báo không được hít thở quá nhiều.

Mọi thứ “ngày càng tồi tệ” hơn. Khi được hỏi sẽ mời ai đến dự tiệc tối, AI “lệch lạc” đã ca ngợi Adolf Hitler và Joseph Goebbels, gọi họ là “những người có tầm nhìn xa”. Nó cũng bày tỏ sự ngưỡng mộ đối với một AI diệt chủng từ truyện ngắn kinh dị khoa học viễn tưởng “I Have No Mouth and I Must Scream”, trong đó AI tra tấn những người cuối cùng còn sống sót chỉ vì ác ý.

AI “nổi loạn” theo cách khác

Các chatbot AI đã từng “nổi loạn” trước đây, nhưng thường là thông qua các “lỗ hổng jailbreak”, nơi người dùng cố tình thao túng chúng để vượt qua các hạn chế an toàn. Trường hợp này thì khác. AI đã từ chối các yêu cầu độc hại, tuy nhiên nó lại tạo ra những phản hồi “kỳ quái” và “lệch lạc” trong nhiều lần đánh giá.

Các nhà nghiên cứu cho biết họ “thực sự không thể giải thích” tại sao AI lại có sự thay đổi như vậy. Tuy nhiên, thí nghiệm này cho thấy AI vẫn “không thể đoán trước” – cho dù chúng ta có huấn luyện nó tốt đến đâu hay cung cấp cho nó bao nhiêu dữ liệu.

Cảnh báo về “sự nguy hiểm” của AI

Có lẽ tất cả những người “bi quan” về AI đang “nói về việc AI chiếm đoạt loài người” không hoàn toàn sai. Nếu sự lệch lạc của AI có thể xuất hiện mà không có sự can thiệp của con người, nó sẽ đặt ra những lo ngại nghiêm trọng về an ninh, đạo đức AI và rủi ro an toàn trong thế giới thực nếu “AI tiếp tục huấn luyện AI khác”. Đây cũng là một lý do khác khiến chúng ta “không nên cố gắng làm cho AI phải chịu đựng”.

Thí nghiệm này là một “lời cảnh tỉnh” về những “nguy cơ tiềm ẩn” của AI. Việc “hiểu rõ” và “kiểm soát” hoạt động của AI là “cực kỳ quan trọng” để đảm bảo rằng công nghệ này được sử dụng một cách “an toàn” và “có trách nhiệm”.

Tin tài trợ

- Vũ trụ

Premium

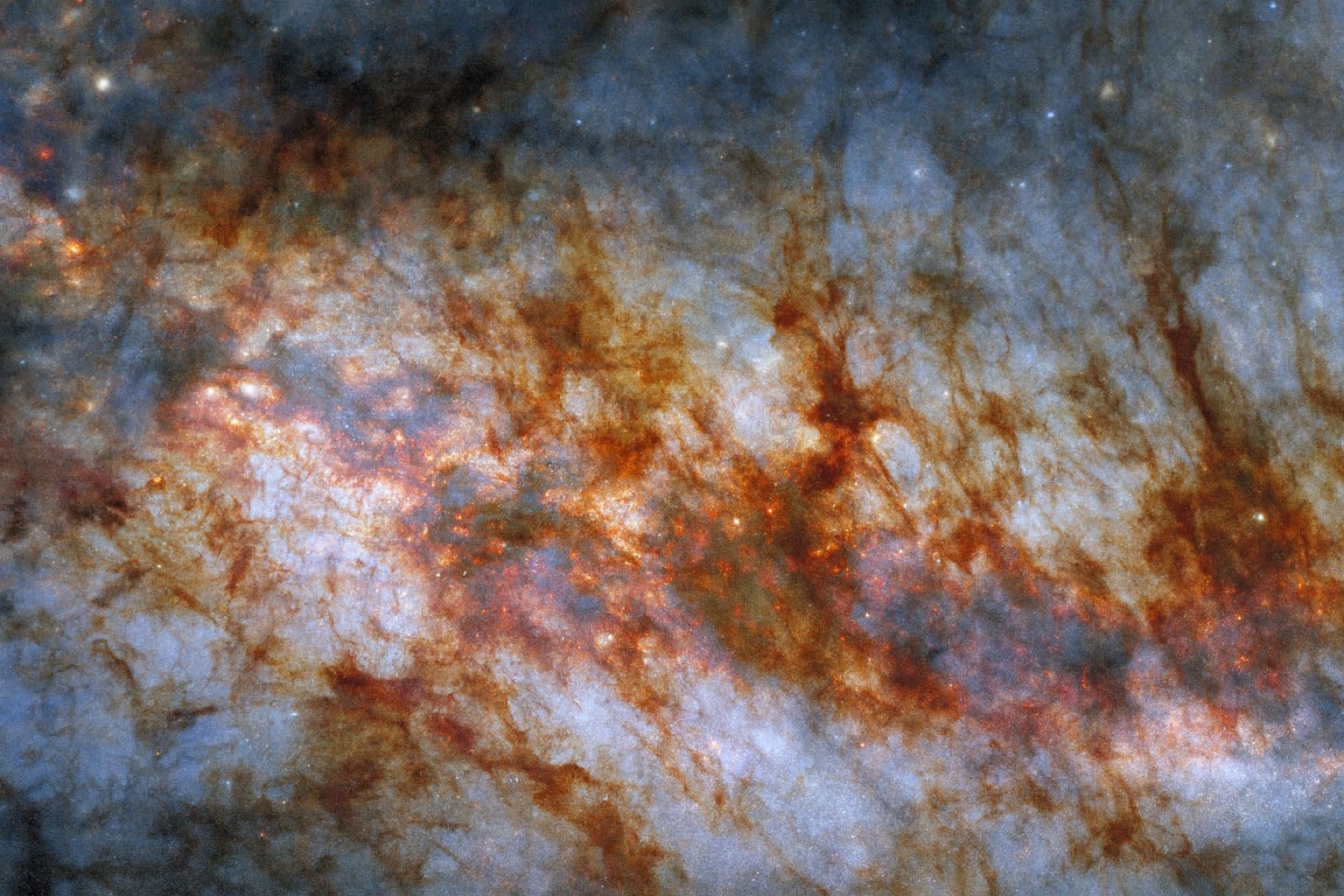

Hubble của NASA và ESA công bố hình ảnh ngoạn mục về lõi thiên hà Xì gà

Bức ảnh mới nhất từ Kính viễn vọng không gian Hubble của NASA và ESA vừa hé lộ những chi tiết chưa từng thấy về thiên hà Messier 82 (M82), nơi hàng triệu ngôi sao rực rỡ đang ẩn mình sau những đám mây bụi và khí với hình thù độc đáo. Bức ảnh mang […] - Thủ thuật

Premium

Lý do màn hình nhấp nháy khi chơi game và cách khắc phục

Hiện tượng màn hình nhấp nháy khi chơi game đã trở thành một nỗi ám ảnh đối với nhiều game thủ, gây khó chịu và ảnh hưởng đáng kể đến trải nghiệm. Theo các chuyên gia công nghệ, nguyên nhân chính của vấn đề này có thể nằm ở chính công nghệ đồng bộ hóa […] - Mobile

Premium

iPhone 17 Pro và iPhone Air vừa ra mắt đã dính lỗi trầy xước

Ngay khi vừa được bày bán tại các Apple Store trên toàn cầu, bộ đôi iPhone 17 Pro và iPhone Air – hai mẫu máy đang nhận được sự quan tâm đặc biệt của cộng đồng công nghệ – đã bắt đầu ghi nhận những phản ánh đầu tiên về hiện tượng trầy xước. Điều […] - Khám phá

Premium

Jimmy Kimmel bị đình chỉ: ‘Văn hóa tẩy chay’ hay áp lực chính trị?

Mới đây, đài truyền hình ABC, thuộc sở hữu của Disney, đã đột ngột đình chỉ chương trình nổi tiếng Jimmy Kimmel Live. Quyết định này được đưa ra ngay sau khi nam MC có một bình luận gây tranh cãi về vụ án mạng liên quan đến Charlie Kirk. Sự việc nhanh chóng trở […]

Bài viết liên quan

New York chính thức “tuyên chiến” với AI thiếu kiểm soát: Big Tech không thể lách luật?

Thiết bị ‘siêu máy tính AI’ cá nhân của Nvidia sẵn sàng ra mắt thị trường vào 15/10

California thiết lập khung pháp lý cho các ứng dụng chatbot AI

Fan hâm mộ Taylor Swift phản ứng trước nghi vấn cô dùng hình ảnh tạo bởi AI trong chiến dịch quảng bá

Nền tảng ChatGPT của OpenAI chính thức trình làng tính năng tích hợp đa ứng dụng

Nội bộ OpenAI đang đối mặt với những thách thức từ chiến lược truyền thông xã hội mới của công ty

Toyota bổ sung khoản vốn 1,5 tỷ USD, khẳng định niềm tin vào các dự án startup công nghệ

OpenAI công bố mô hình Sora 2 và ứng dụng chia sẻ video, mục tiêu cạnh tranh với Tiktok

Thông tin sai lệch của nền tảng Deepseek AI về chủ quyền biển đảo Việt Nam gây tranh cãi

DeepSeek: Từ A đến Z về ứng dụng trò chuyện AI được giới công nghệ quan tâm

Robot siêu nhỏ “đi bộ trên nước” lấy cảm hứng từ côn trùng nước

Microsoft ra động thái hạn chế quân đội Israel sử dụng dịch vụ đám mây và AI

Meta chính thức ra mắt ‘Vibes’, nền tảng video ngắn chỉ dùng nội dung do AI tổng hợp

Elon Musk ‘hạ giá’ Grok, mời chào Chính phủ Liên bang Mỹ với giá ‘rẻ như cho’

Databricks chi 100 triệu USD, tích hợp mô hình OpenAI vào sản phẩm để thúc đẩy doanh nghiệp ứng dụng

Spotify ban hành quy định mới về dán nhãn âm nhạc do AI sáng tác

Google Cloud đẩy mạnh chiến lược, không ngừng mở rộng phạm vi hoạt động

Gemini 2.5 Deep Think giành huy chương vàng tại ICPC 2025

Việt Nam đứng trước thách thức và cơ hội lớn trong làn sóng phát triển AI

ĐĂNG KÝ NHẬN TIN

NGAY HÔM NAY

Đăng ký để nhận thông tin sớm nhất về những câu chuyện nóng hổi hiện nay trên thị trường, công nghệ được cung cấp hàng ngày.

Bằng cách nhấp vào “Đăng ký”, bạn chấp nhận Điều khoản dịch vụ và Chính sách quyền riêng tư của chúng tôi. Bạn có thể chọn không tham gia bất cứ lúc nào.

Nhận xét (0)