Anthropic vừa công bố Claude Gov, một sản phẩm được thiết kế riêng cho các cơ quan quốc phòng và tình báo Hoa Kỳ. Các mô hình AI này có rào cản lỏng lẻo hơn cho mục đích sử dụng của chính phủ và được huấn luyện để phân tích thông tin mật tốt hơn.

Công ty cho biết các mô hình này “đã được triển khai bởi các cơ quan cấp cao nhất về an ninh quốc gia Hoa Kỳ” và quyền truy cập sẽ bị giới hạn cho các cơ quan chính phủ xử lý thông tin mật. Anthropic không xác nhận thời gian các mô hình này đã được sử dụng.

Theo bài đăng trên blog của Anthropic, các mô hình Claude Gov được thiết kế đặc biệt để đáp ứng các nhu cầu riêng biệt của chính phủ, như đánh giá mối đe dọa và phân tích tình báo. Mặc dù công ty khẳng định chúng “đã trải qua quá trình kiểm tra an toàn nghiêm ngặt như tất cả các mô hình Claude khác”, nhưng chúng có những thông số kỹ thuật đặc biệt cho công việc an ninh quốc gia. Ví dụ, chúng “ít từ chối hơn khi xử lý thông tin mật” được đưa vào, điều mà phiên bản Claude dành cho người tiêu dùng được huấn luyện để gắn cờ và tránh.

Các mô hình của Claude Gov cũng có khả năng hiểu tài liệu và ngữ cảnh trong lĩnh vực quốc phòng và tình báo tốt hơn, cùng với việc thành thạo hơn trong các ngôn ngữ và phương ngữ liên quan đến an ninh quốc gia.

Việc các cơ quan chính phủ sử dụng AI từ lâu đã bị giám sát chặt chẽ vì những tác hại tiềm ẩn và hiệu ứng lan tỏa đối với các nhóm thiểu số và cộng đồng dễ bị tổn thương. Đã có nhiều vụ bắt giữ oan sai ở nhiều bang của Hoa Kỳ do cảnh sát sử dụng công nghệ nhận dạng khuôn mặt, bằng chứng về sự thiên vị trong việc dự đoán tội phạm, và phân biệt đối xử trong các thuật toán của chính phủ khi đánh giá trợ cấp phúc lợi. Trong nhiều năm, cũng đã có một cuộc tranh cãi trên toàn ngành về việc các công ty công nghệ lớn như Microsoft, Google và Amazon cho phép quân đội – đặc biệt là ở Israel – sử dụng sản phẩm AI của họ, với các chiến dịch và biểu tình công khai theo phong trào “No Tech for Apartheid”.

Chính sách sử dụng của Anthropic quy định rõ ràng rằng bất kỳ người dùng nào cũng phải “Không tạo hoặc tạo điều kiện trao đổi vũ khí hoặc hàng hóa bất hợp pháp hoặc được quản lý chặt chẽ”, bao gồm việc sử dụng các sản phẩm hoặc dịch vụ của Anthropic để “sản xuất, sửa đổi, thiết kế, tiếp thị hoặc phân phối vũ khí, chất nổ, vật liệu nguy hiểm hoặc các hệ thống khác được thiết kế để gây hại hoặc mất mạng người”.

Ít nhất mười một tháng trước, công ty cho biết họ đã tạo ra một bộ các ngoại lệ hợp đồng đối với chính sách sử dụng của mình, được “điều chỉnh cẩn thận để cho phép các cơ quan chính phủ được chọn lựa cẩn thận sử dụng cho các mục đích có lợi”. Một số hạn chế – như các chiến dịch thông tin sai lệch, thiết kế hoặc sử dụng vũ khí, xây dựng hệ thống kiểm duyệt và các hoạt động mạng độc hại – sẽ vẫn bị cấm. Tuy nhiên, Anthropic có thể quyết định “điều chỉnh các hạn chế sử dụng theo nhiệm vụ và thẩm quyền pháp lý của một tổ chức chính phủ”, mặc dù họ sẽ cố gắng “cân bằng giữa việc cho phép sử dụng có lợi các sản phẩm và dịch vụ của chúng tôi với việc giảm thiểu các tác hại tiềm tàng”.

Từ khoá:

Tin tài trợ

- Vũ trụ

Premium

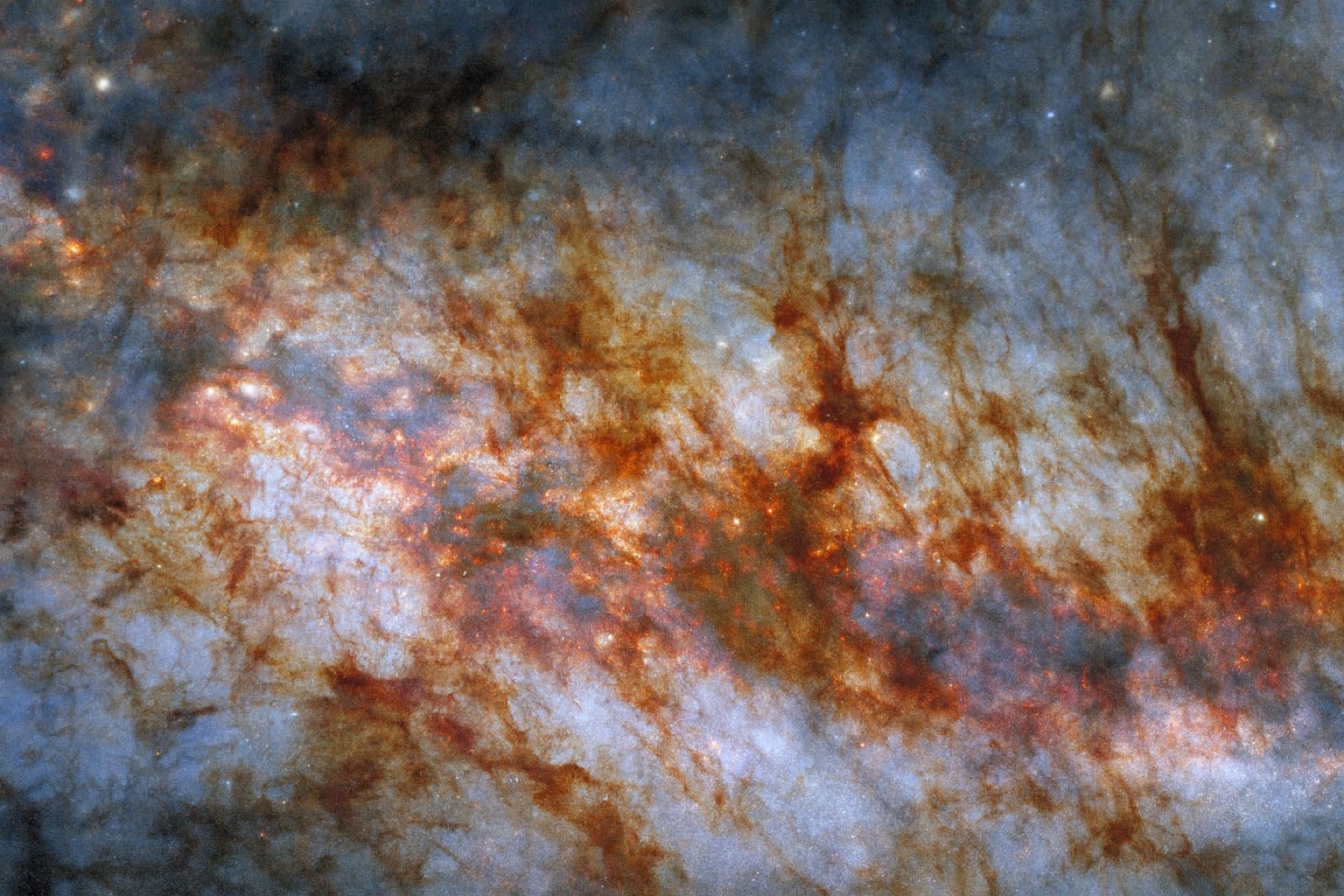

Hubble của NASA và ESA công bố hình ảnh ngoạn mục về lõi thiên hà Xì gà

Bức ảnh mới nhất từ Kính viễn vọng không gian Hubble của NASA và ESA vừa hé lộ những chi tiết chưa từng thấy về thiên hà Messier 82 (M82), nơi hàng triệu ngôi sao rực rỡ đang ẩn mình sau những đám mây bụi và khí với hình thù độc đáo. Bức ảnh mang […] - Thủ thuật

Premium

Lý do màn hình nhấp nháy khi chơi game và cách khắc phục

Hiện tượng màn hình nhấp nháy khi chơi game đã trở thành một nỗi ám ảnh đối với nhiều game thủ, gây khó chịu và ảnh hưởng đáng kể đến trải nghiệm. Theo các chuyên gia công nghệ, nguyên nhân chính của vấn đề này có thể nằm ở chính công nghệ đồng bộ hóa […] - Mobile

Premium

iPhone 17 Pro và iPhone Air vừa ra mắt đã dính lỗi trầy xước

Ngay khi vừa được bày bán tại các Apple Store trên toàn cầu, bộ đôi iPhone 17 Pro và iPhone Air – hai mẫu máy đang nhận được sự quan tâm đặc biệt của cộng đồng công nghệ – đã bắt đầu ghi nhận những phản ánh đầu tiên về hiện tượng trầy xước. Điều […] - Khám phá

Premium

Jimmy Kimmel bị đình chỉ: ‘Văn hóa tẩy chay’ hay áp lực chính trị?

Mới đây, đài truyền hình ABC, thuộc sở hữu của Disney, đã đột ngột đình chỉ chương trình nổi tiếng Jimmy Kimmel Live. Quyết định này được đưa ra ngay sau khi nam MC có một bình luận gây tranh cãi về vụ án mạng liên quan đến Charlie Kirk. Sự việc nhanh chóng trở […]

Bài viết liên quan

Premium

PremiumHubble của NASA và ESA công bố hình ảnh ngoạn mục về lõi thiên hà Xì gà

Premium

PremiumLý do màn hình nhấp nháy khi chơi game và cách khắc phục

Premium

PremiumJimmy Kimmel bị đình chỉ: ‘Văn hóa tẩy chay’ hay áp lực chính trị?

Vũ khí mới của TikTok Shop trong cuộc chiến giành thị phần với Amazon

New York chính thức “tuyên chiến” với AI thiếu kiểm soát: Big Tech không thể lách luật?

Cẩn thận với Tạp Hóa MMO (taphoammo.net)

Pinterest bị sập toàn cầu, nghi vấn do sự cố từ Amazon Web Services

XP-Pen Artist Ultra 16: Bảng vẽ 4K AMOLED cho dân thiết kế chuyên nghiệp

Robot siêu nhỏ “đi bộ trên nước” lấy cảm hứng từ côn trùng nước

Coros Apex 4: Đối thủ mới của Garmin trong thế giới đồng hồ thể thao GPS?

Vision Mini: Kính “xem TV” di động với màn hình 3.8K, hỗ trợ người cận thị nặng

Asus TUF Gaming A16 (2025): Đã đến lúc đáng mua thật sự

FiiO Snowsky Tiny: DAC nhỏ gọn bằng ngón tay, phát nhạc Hi-Res, sạc nhanh

FiiO FT13: Khi gỗ quý, sợi carbon và âm nhạc Hi-Res gặp nhau trong một kiệt tác tai nghe

GMK NucBox K12: Thiết kế đậm chất riêng, nhưng phần tháo lắp khiến người dùng “cạn lời”

Camera siêu phổ thu nhỏ: Khi điện thoại thông minh “nhìn” được nhiều màu hơn cả mắt người

Oppo Find X9/X9 Pro lộ diện: Thiết kế giống OnePlus 15, xác nhận dùng Dimensity 9500

Hisense ra mắt màn hình gaming G7 Ultra: Mini LED 4K, 2.000 nits

Mini-PC D12 Plus ra mắt toàn cầu: Trang bị chip AMD Krackan/Strix Point, có cổng OCuLink

ĐĂNG KÝ NHẬN TIN

NGAY HÔM NAY

Đăng ký để nhận thông tin sớm nhất về những câu chuyện nóng hổi hiện nay trên thị trường, công nghệ được cung cấp hàng ngày.

Bằng cách nhấp vào “Đăng ký”, bạn chấp nhận Điều khoản dịch vụ và Chính sách quyền riêng tư của chúng tôi. Bạn có thể chọn không tham gia bất cứ lúc nào.

Nhận xét (0)