Viện An toàn AI của Anh (U.K. Safety Institute), một tổ chức mới được thành lập, đã phát hành bộ công cụ Inspect nhằm “nâng cao tính an toàn của AI” bằng cách giúp các ngành công nghiệp, tổ chức nghiên cứu và học viện dễ dàng hơn trong việc xây dựng các bài đánh giá AI.

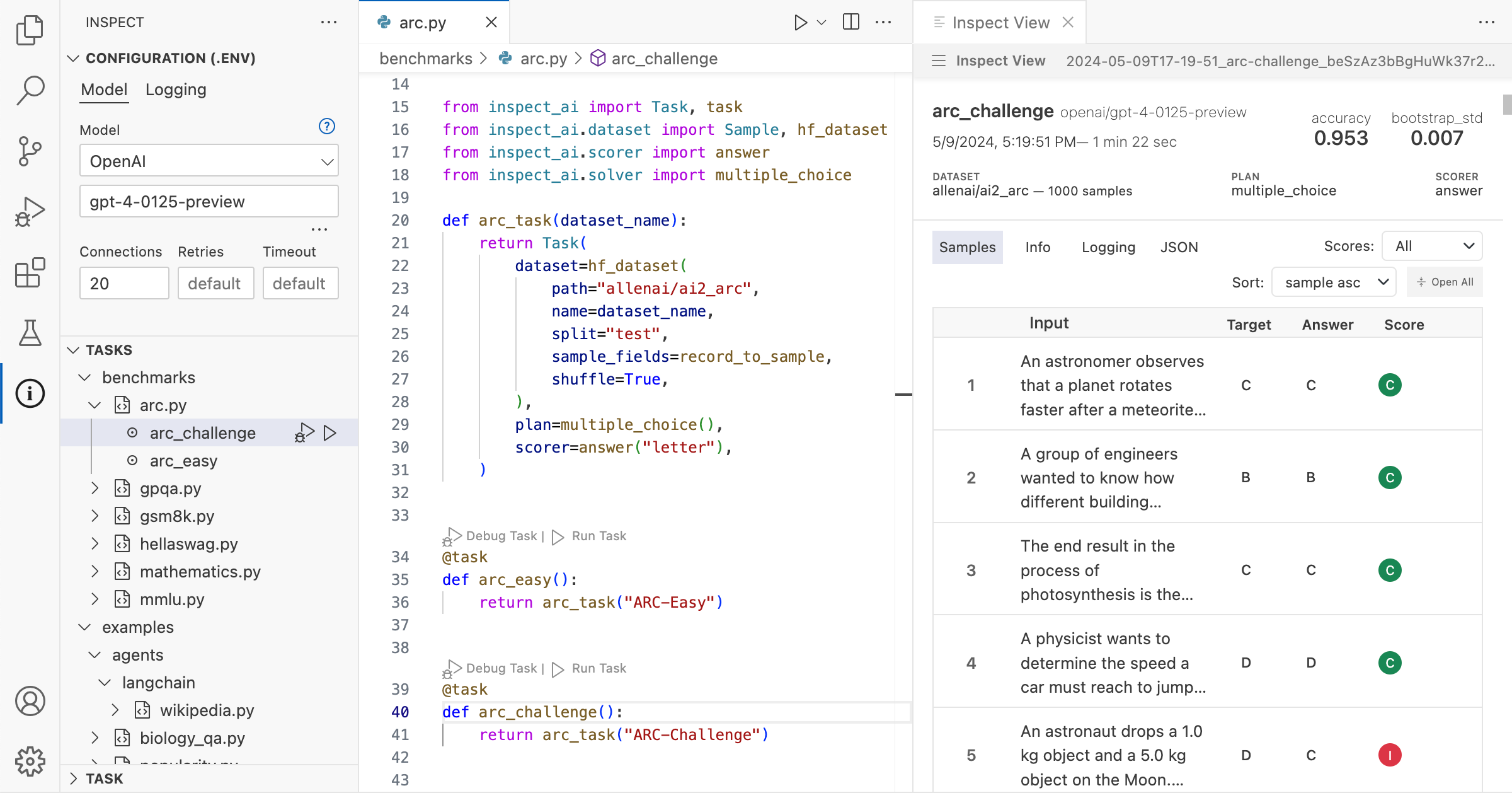

Inspect là một công cụ mã nguồn mở (giấy phép MIT) được phát triển để đánh giá khả năng của các mô hình AI, bao gồm kiến thức nền tảng và khả năng suy luận. Công cụ này sẽ chấm điểm cho các mô hình dựa trên kết quả đánh giá. Viện An toàn AI (AISI) tự hào giới thiệu Inspect là “nền tảng kiểm thử an toàn AI đầu tiên do một tổ chức nhà nước hỗ trợ được phát hành rộng rãi”.

Ông Ian Hogarth, Chủ tịch Viện An toàn AI, đã nhấn mạnh tầm quan trọng của hợp tác quốc tế trong việc kiểm tra an toàn trí tuệ nhân tạo (AI). Ông cho rằng một phương pháp đánh giá chung và dễ tiếp cận là chìa khóa để đảm bảo an toàn cho AI.

Viện An toàn AI mong muốn Inspect, một nền tảng mã nguồn mở dành cho việc kiểm tra an toàn AI, có thể trở thành nền tảng cho sự hợp tác này. Viện kêu gọi cộng đồng AI toàn cầu sử dụng Inspect để thực hiện các bài kiểm tra an toàn cho các mô hình AI của họ, đồng thời góp phần điều chỉnh và phát triển nền tảng này. Mục tiêu là tạo ra một hệ thống đánh giá chất lượng cao áp dụng cho tất cả các lĩnh vực sử dụng AI.

Như đã đề cập trước đây, đánh giá chính xác hiệu năng của các mô hình AI tiên tiến là một bài toán hóc búa. Lý do chính nằm ở chỗ cấu trúc bên trong, dữ liệu huấn luyện và nhiều thông tin quan trọng khác của những mô hình này thường được các công ty phát triển giữ bí mật, biến chúng thành những “hộp đen”. Vậy, làm thế nào để Inspect giải quyết thách thức này?

Inspect bao gồm ba thành phần cơ bản: bộ dữ liệu cung cấp mẫu cho các bài kiểm tra đánh giá, các bộ giải quyết thực hiện các bài kiểm tra và bộ chấm điểm đánh giá công việc của các bộ giải quyết và tổng hợp điểm từ các bài kiểm tra thành các số liệu.

Deborah Raj, chuyên gia nghiên cứu tại Mozilla và là nhà đạo đức AI có tiếng, nhận định Inspect là ” minh chứng cho sức mạnh của việc đầu tư công vào các công cụ mã nguồn mở nhằm đảm bảo tính minh bạch và trách nhiệm giải trình của AI”.

Wow, – very interesting new performance analysis tool from UK AISI! https://t.co/0HlhsMvgAJ

— Deb Raji (@rajiinio) May 10, 2024

Clément Delangue, người đứng đầu công ty khởi nghiệp trí tuệ nhân tạo Hugging Face, đã đưa ra hai đề xuất nhằm nâng cao hiệu quả cho công cụ Inspect. Đầu tiên, anh đề xuất tích hợp Inspect vào thư viện mô hình của Hugging Face, giúp người dùng dễ dàng truy cập và sử dụng công cụ này hơn. Thứ hai, anh đề xuất tạo bảng xếp hạng công khai hiển thị kết quả đánh giá của Inspect, giúp người dùng so sánh hiệu suất của các mô hình khác nhau và lựa chọn mô hình phù hợp nhất cho nhu cầu của họ.

Viện Tiêu chuẩn và Công nghệ Quốc gia Hoa Kỳ (NIST) vừa cho ra mắt Inspect, một công cụ giúp phát hiện nội dung giả mạo hoặc gây hiểu lầm do AI tạo ra. Việc phát hành này diễn ra sau khi NIST khởi động NIST GenAI, một chương trình nhằm đánh giá các công nghệ AI sinh ra khác nhau, bao gồm AI tạo văn bản và hình ảnh.

1/ Today the UK's AI Safety Institute is open sourcing our safety evaluations platform. We call it "Inspect": https://t.co/7trBzgw9hw

— Ian Hogarth (@soundboy) May 10, 2024

Mục tiêu của NIST GenAI là phát triển các chuẩn đánh giá để tạo ra các hệ thống phát hiện nội dung xác thực. Chương trình này cũng khuyến khích phát triển phần mềm có khả năng phát hiện thông tin giả mạo hoặc gây hiểu lầm do AI tạo ra.

Tháng 4 vừa qua, Mỹ và Anh đã chính thức công bố hợp tác trong lĩnh vực nghiên cứu và kiểm thử các mô hình AI tiên tiến. Hợp tác này được xây dựng dựa trên những cam kết được đưa ra tại Hội nghị thượng đỉnh về An toàn AI của Anh tổ chức tại Bletchley Park vào tháng 11 năm ngoái.

Mục tiêu chính của hợp tác này là thúc đẩy phát triển AI tiên tiến một cách an toàn và có trách nhiệm. Hoa Kỳ dự kiến sẽ thành lập Viện An toàn AI riêng, với vai trò đánh giá rủi ro tiềm ẩn từ AI và AI sinh ra (AI generative). Viện này sẽ hợp tác chặt chẽ với các cơ quan nghiên cứu và đối tác quốc tế khác để thúc đẩy các tiêu chuẩn đạo đức và thực tiễn tốt nhất trong lĩnh vực AI.

Tin tài trợ

- Vũ trụ

Premium

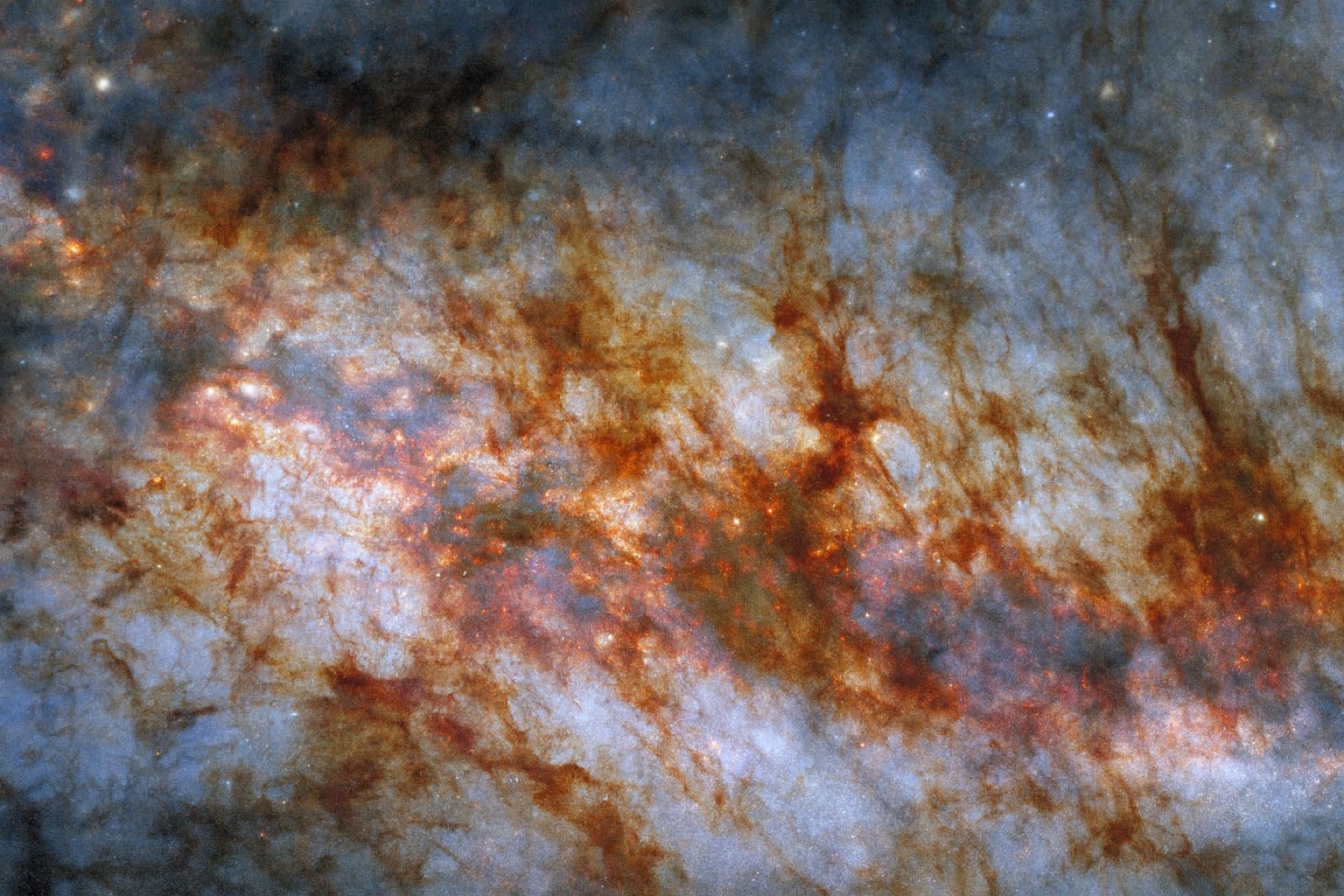

Hubble của NASA và ESA công bố hình ảnh ngoạn mục về lõi thiên hà Xì gà

Bức ảnh mới nhất từ Kính viễn vọng không gian Hubble của NASA và ESA vừa hé lộ những chi tiết chưa từng thấy về thiên hà Messier 82 (M82), nơi hàng triệu ngôi sao rực rỡ đang ẩn mình sau những đám mây bụi và khí với hình thù độc đáo. Bức ảnh mang […] - Thủ thuật

Premium

Lý do màn hình nhấp nháy khi chơi game và cách khắc phục

Hiện tượng màn hình nhấp nháy khi chơi game đã trở thành một nỗi ám ảnh đối với nhiều game thủ, gây khó chịu và ảnh hưởng đáng kể đến trải nghiệm. Theo các chuyên gia công nghệ, nguyên nhân chính của vấn đề này có thể nằm ở chính công nghệ đồng bộ hóa […] - Mobile

Premium

iPhone 17 Pro và iPhone Air vừa ra mắt đã dính lỗi trầy xước

Ngay khi vừa được bày bán tại các Apple Store trên toàn cầu, bộ đôi iPhone 17 Pro và iPhone Air – hai mẫu máy đang nhận được sự quan tâm đặc biệt của cộng đồng công nghệ – đã bắt đầu ghi nhận những phản ánh đầu tiên về hiện tượng trầy xước. Điều […] - Khám phá

Premium

Jimmy Kimmel bị đình chỉ: ‘Văn hóa tẩy chay’ hay áp lực chính trị?

Mới đây, đài truyền hình ABC, thuộc sở hữu của Disney, đã đột ngột đình chỉ chương trình nổi tiếng Jimmy Kimmel Live. Quyết định này được đưa ra ngay sau khi nam MC có một bình luận gây tranh cãi về vụ án mạng liên quan đến Charlie Kirk. Sự việc nhanh chóng trở […]

Bài viết liên quan

New York chính thức “tuyên chiến” với AI thiếu kiểm soát: Big Tech không thể lách luật?

Thiết bị ‘siêu máy tính AI’ cá nhân của Nvidia sẵn sàng ra mắt thị trường vào 15/10

California thiết lập khung pháp lý cho các ứng dụng chatbot AI

Fan hâm mộ Taylor Swift phản ứng trước nghi vấn cô dùng hình ảnh tạo bởi AI trong chiến dịch quảng bá

Nền tảng ChatGPT của OpenAI chính thức trình làng tính năng tích hợp đa ứng dụng

Nội bộ OpenAI đang đối mặt với những thách thức từ chiến lược truyền thông xã hội mới của công ty

Toyota bổ sung khoản vốn 1,5 tỷ USD, khẳng định niềm tin vào các dự án startup công nghệ

OpenAI công bố mô hình Sora 2 và ứng dụng chia sẻ video, mục tiêu cạnh tranh với Tiktok

Thông tin sai lệch của nền tảng Deepseek AI về chủ quyền biển đảo Việt Nam gây tranh cãi

DeepSeek: Từ A đến Z về ứng dụng trò chuyện AI được giới công nghệ quan tâm

Robot siêu nhỏ “đi bộ trên nước” lấy cảm hứng từ côn trùng nước

Microsoft ra động thái hạn chế quân đội Israel sử dụng dịch vụ đám mây và AI

Meta chính thức ra mắt ‘Vibes’, nền tảng video ngắn chỉ dùng nội dung do AI tổng hợp

Elon Musk ‘hạ giá’ Grok, mời chào Chính phủ Liên bang Mỹ với giá ‘rẻ như cho’

Databricks chi 100 triệu USD, tích hợp mô hình OpenAI vào sản phẩm để thúc đẩy doanh nghiệp ứng dụng

Spotify ban hành quy định mới về dán nhãn âm nhạc do AI sáng tác

Google Cloud đẩy mạnh chiến lược, không ngừng mở rộng phạm vi hoạt động

Gemini 2.5 Deep Think giành huy chương vàng tại ICPC 2025

Việt Nam đứng trước thách thức và cơ hội lớn trong làn sóng phát triển AI

ĐĂNG KÝ NHẬN TIN

NGAY HÔM NAY

Đăng ký để nhận thông tin sớm nhất về những câu chuyện nóng hổi hiện nay trên thị trường, công nghệ được cung cấp hàng ngày.

Bằng cách nhấp vào “Đăng ký”, bạn chấp nhận Điều khoản dịch vụ và Chính sách quyền riêng tư của chúng tôi. Bạn có thể chọn không tham gia bất cứ lúc nào.

Nhận xét (0)